No hay productos en el carrito

El origen del deepfake

La primera vez que se utilizó el término «deepfake» fue a finales de 2017 por un usuario de Reddit del mismo nombre. Este usuario creó una serie de publicaciones donde compartió videos pornográficos de actrices reconocidas que usaban tecnología de intercambio de rostros de código abierto.

Sin embargo, esta no es la primera vez que convivimos o nos enfrentamos a fakes audiovisuales, el cine y la televisión nos presentaron este tipo de contenidos con formatos como los mockumentaries (falsos documentales), incluso la radio había tenido sus propias incursiones con creadores como Orson Wells y su retransmisión radiofónica de 1938, misma que adaptó de la historia de la obra más emblemática del novelista inglés H. G. Wells, La guerra de los mundos.

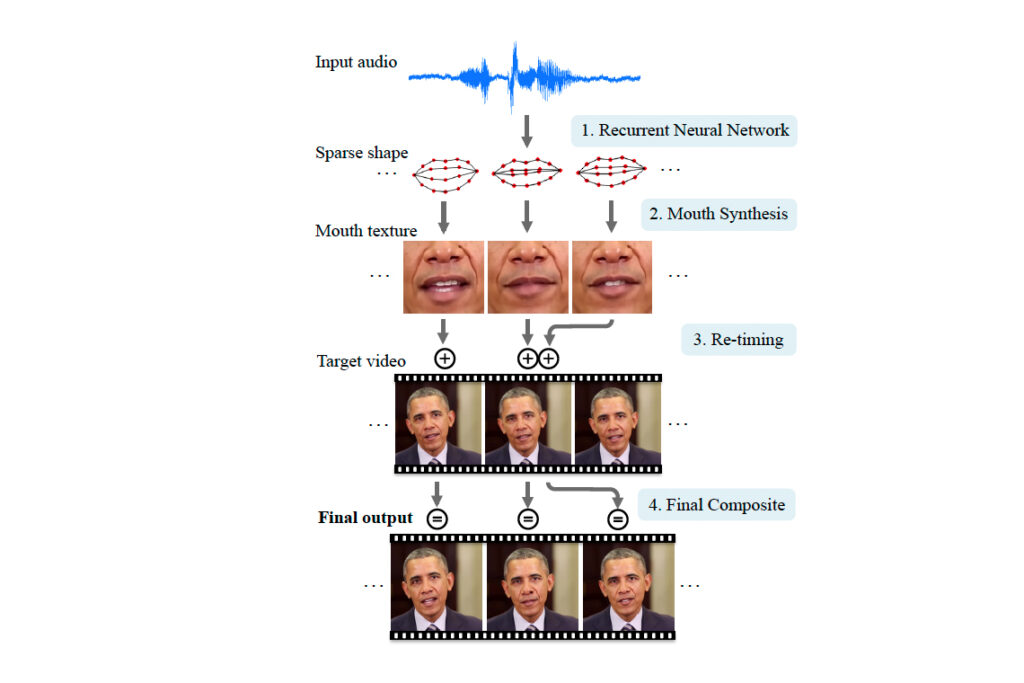

Ya en tiempos más modernos (1997), tenemos el ejemplo del programa Video Rewrite de Christoph Bregler, Michele Covell y Malcolm Slaney, que modificó las imágenes de video existentes de una persona hablando para representar a esa misma persona pronunciando palabras contenidas en una pista de audio diferente.

Este fue el primer sistema en automatizar completamente este tipo de reanimación facial. Lo hizo utilizando técnicas de aprendizaje automático para establecer conexiones entre los sonidos producidos por el sujeto de un video y la forma de su rostro. Originalmente fue diseñado para usarlo en el doblaje de películas, lo que permitía modificar la secuencia de la película para sincronizar los movimientos de los labios de los actores con un nuevo audio.

La diferencia de todos estos ejemplos que antecedieron a la acuñación del término es que siempre había un aviso de los autores informando que el contenido era falso.

¿Cómo funciona un deepfake?

Los deepfakes utilizan Redes Generativas Antagónicas (RGAs), también conocidas como GANs en inglés, son una clase de algoritmos de Inteligencia Artificial que se utilizan en el aprendizaje no supervisado, implementadas por un sistema de dos redes neuronales que compiten mutuamente en una especie de juego de suma cero, de ahí el término antagónicas.

De tal forma que el primer modelo es alimentado con una base de datos de referentes visuales, ya sean fotografías o vídeos y con esta base empieza a generar imágenes falsificadas. El otro modelo por su parte se encarga de detectar las imágenes falsas creadas por el primer modelo, este ciclo se repite hasta que eventualmente el primer modelo logra generar una imagen que el segundo modelo no logra identificar como falsa.

En síntesis, hay dos inteligencias artificiales, la primera tiene que generar, a partir de cierta data, imágenes falsificadas hasta lograr engañar a la segunda inteligencia artificial.

Teniendo lo anterior presente, es claro ahora entender por qué el uso de esta tecnología ha sido dirigida primordialmente a figuras públicas. Debido a la vasta cantidad de contenido audiovisual que existe de estas personas, es fácil alimentar a la base de datos del modelo para poder crear imágenes falsas convincentes aunque por supuesto eso no lo justifica.

Hay algo importante a destacar, mientras el usuario de Reddit acuñaba el término, un grupo de investigadores de la Universidad de Washington publicaron una investigación llamada SIGGRAPH 2017, en la que detallaron cómo es que habían logrado utilizar un audio del entonces presidente Obama para colocarlo en otro video, sincronizando de manera casi perfecta el audio original con el nuevo video.

Mi pregunta es, ¿quién logró avanzar más rápido? ¿Un grupo de especialistas subvencionados por una Universidad de prestigio o un “hacker anónimo” que colocaba rostros de mujeres famosas en videos pornográficos?

Según lo revelado por el usuario de Reddit, utilizó software basado en varias bibliotecas de código abierto, como Keras con el backend de TensorFlow (proveído por Google). Para compilar las caras de las celebridades, «deepfakes» dijo que usó la búsqueda de imágenes de Google, fotos de archivo y videos de YouTube. En este caso, entrenó al algoritmo con videos porno y con la cara de las celebridades. Después de suficiente «entrenamiento», los nodos se organizaron para manipular videos de manera convincente.

Tanto los investigadores como el redditero, usaron el mismo procedimiento, lo que revela la gran facilidad con la que alguien podría hacer esto. Aparte del desafío técnico, todo lo que alguien necesitaría son suficientes imágenes, y muchos de nosotros ya hemos cedido nuestros rostros al crear de manera consciente o inconsciente bases de datos de nuestras caras: 93 millones de selfies son tomadas cada día solo desde dispositivos Android. No es difícil imaginar a un programador aficionado ejecutando su propio algoritmo para crear un video sexual donde tú seas la próxima víctima.

Más tarde en 2018, Jordan Peele y BuzzFeed, se unieron, usando algunas de las últimas técnicas de inteligencia artificial, Peele prácticamente ventriloquizó a Barack Obama, haciéndole expresar su opinión sobre Black Panther y logrando que llamara al presidente Donald Trump «un total y completo idiota».

El video fue realizado por la compañía de producción de Peele utilizando una combinación de tecnología antigua y nueva: Adobe After Effects y la herramienta de intercambio de caras de FakeApp.

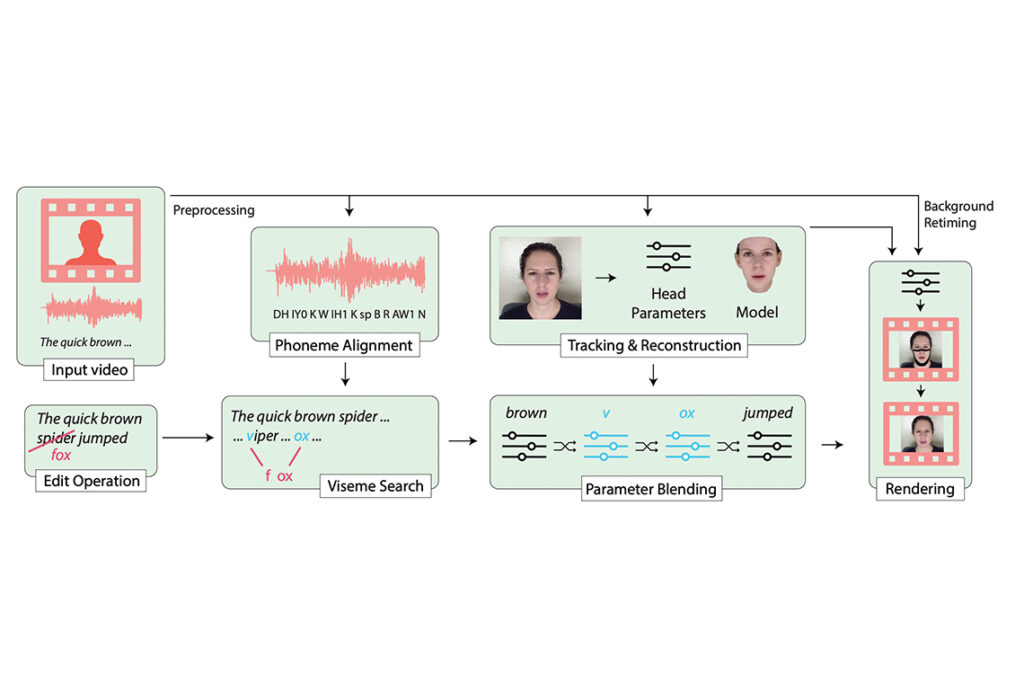

En 2019, científicos de la Universidad de Stanford, el Instituto Max Planck de Informática, la Universidad de Princeton y Adobe Research, mostraron que la capacidad para editar lo que la gente dice en videos y crear falsificaciones realistas es cada día más fácil.

Para crear falsificaciones de video, los científicos combinan varias técnicas. Primero, escanean el video de destino para aislar los fonemas hablados por el sujeto. Luego relacionan estos fonemas con los visemas correspondientes, que son las expresiones faciales que acompañan a cada sonido. Finalmente, crean un modelo 3D de la mitad inferior de la cara del sujeto usando el video de destino.

Cuando alguien edita una transcripción de texto del video, el software combina todos estos datos recopilados (fonemas, visemas y modelo de rostro en 3D) para construir nuevas imágenes que coincidan con la entrada de texto. Esto luego se pega en el video de origen para crear el resultado final.

El deepfake en cifras

En 2019, la empresa de ciberseguridad Deeptrace, encontró que existían 14,678 videos deepfake en línea, en comparación con los 7,964 de diciembre de 2018.

Dijeron que el 96% eran de naturaleza pornográfica, frecuentemente con un rostro generado por computadora de una celebridad que reemplazaba a la del actor adulto original en una escena de actividad sexual.

La propia existencia de empresas como Deeptrace nos deja ver claramente la rapidez con la que el fenómeno deepfake se ha convertido en una preocupación para las corporaciones y los gobiernos.

Basta con ver su misión que pareciera haber sido extraída de una película de ciencia ficción:

“Proteger a personas y organizaciones de los impactos dañinos de los medios sintéticos generados por IA».

En el mismo informe también se describen portales de servicios, empresas en línea que generan y venden videos deepfake.

Uno de esos portales solicita a quién lo contrata 250 fotos del sujeto objetivo y dos días de procesamiento para generar un video. Los precios cobrados varían, pero pueden ser de tan solo $2.99 dólares por video.

En otro reporte del mismo año realizado por WITNESS, en asociación con la Universidad George Washington, se expresa que en este momento, la simulación de rostros reales de manera completamente realista aún involucra a un equipo significativo de personas con habilidades y tecnología especializadas.

Pero el largo proceso se está automatizando, lo que permite que personas sin ese conocimiento especializado logren hacer videos y generarlos mucho más rápido.

Basta con observar los resultados provenientes de la búsqueda del hashtag #deepfake en YouTube, hay algunos ejemplos impresionantes de cómo se está utilizando la tecnología.

Deepfake y reconocimiento facial

Por supuesto que todo este tema de deepfakes no podría existir sin tecnologías que le han precedido y de las que finalmente se alimenta, una de ellas es el tema de reconocimiento facial, donde como comentaba anteriormente nuestros rostros ya no nos pertenecen y ahora forman parte del mercado capitalista en donde están a la espera de venderse al mejor postor.

Si bien en países como Rusia o China el uso de este tipo de tecnologías es ya parte de su cultura y de su modus vivendi, de este lado del continente aún hay mucho discutiéndose ahora mismo, sobre todo en Estados Unidos, no solo por ser quienes lideran la conversación tecnológica sino porque la mayoría de las empresas de reconocimiento facial tienen sede en este país.

Tal es el caso de la polémica y controversial empresa ClearView AI quien en diversas teorías de conspiración ha sido señalada de orquestar el amotinamiento que se lllevó a cabo en el congreso estadounidense días antes de la sucesión del poder.

Las razones que sostienen estas teorías son muy claras y es que ClearView AI se ha convertido en uno de los proveedores más importantes sobre todo para el FBI, ayudándoles a identificar sospechosos e incluso logrando encontrar culpables, gracias a que esta compañía tiene acceso a millones de imágenes de rostros, hasta ahora a pesar de que tiene demandas activas nadie realmente ha podido hacer nada en contra de la empresa quien se defiende apelando a la Tercera Enmienda.

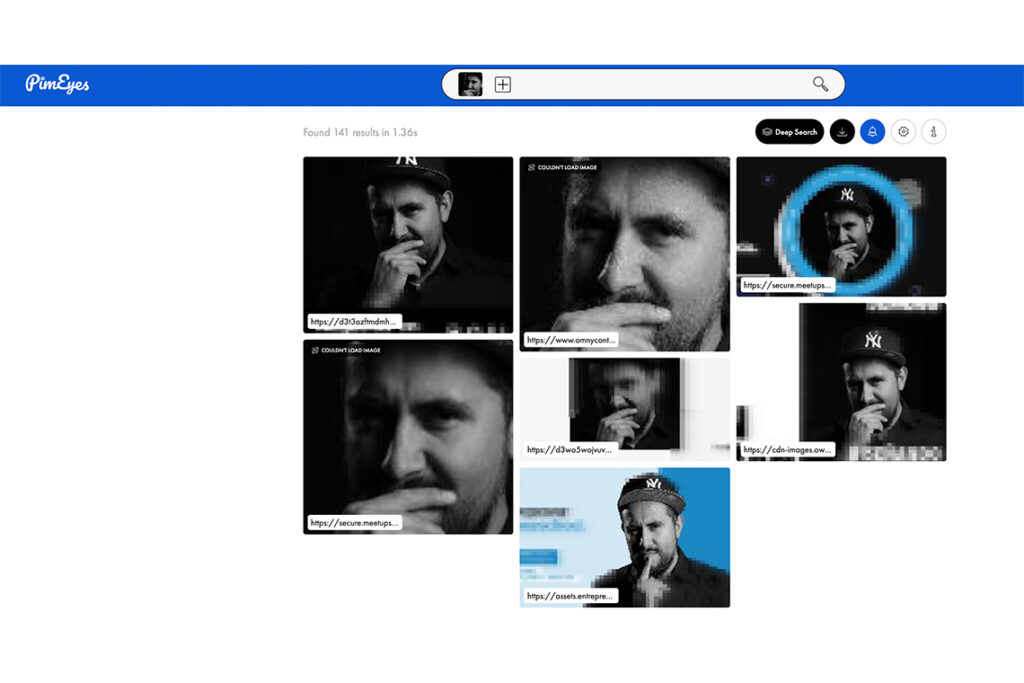

Sin embargo, actualmente no necesitamos tener acceso a tecnología tan sofisticada, un claro ejemplo es PimEyes, una empresa de reconocimiento facial asequible, en la que cualquier persona puede buscar el rostro de cualquier persona en Internet, accediendo a la data disponible que haya en la red de esa persona.

Imagina lo que haríamos con una aplicación de identificación de rostros en nuestros teléfonos. Todos esos trolls anónimos en redes sociales dejarían de ser simples seudónimos, podríamos descubrir realmente quienes son.

¿En qué sociedad nos convertiríamos si se acaba con el anonimato?

Tú tambien estás alimentando a los deepfakes

El denominado síndrome de la rana hervida es una analogía que se usa para describir el fenómeno ocurrido cuando un problema es progresivamente tan lento que sus daños pueden percibirse como daños a largo plazo o no percibirse, la falta de conciencia genera que no haya reacciones o que estas sean tan tardías como para evitar o revertir los daños que ya están hechos.

Esto nos está pasando con esta y muchas tecnologías, se están infiltrando de poco en poco en nuestras vidas, en formas de apps inofensivas que después terminarán siendo armas de espionaje de máximo nivel.

Si ahora mismo te pregunto cuántas veces has fomentado e incluso ayudado al desarrollo de deepfakes seguro tu respuesta sería algo así como “yo jamás apoyaría a este tipo de tecnologías tan perversas”.

Sin embargo, si cambio la pregunta y ahora te cuestiono sobre cuántas veces has utilizado aplicaciones de cambio de rostro, de simulación de envejecimiento o de rejuvenecimiento, incluso aquellas de cambio de sexo o las más recientes de resurección de gente muerta como My Heritage, seguro tu respuesta sería que sí las has utilizado pero con fines meramente de exploración y/o entretenimiento.

Te tengo malas noticias, cada vez que usas estas aplicaciones le permites a la inteligencia a prender más al respecto, corregir errores y seguir evolucionando, así que si has usado cualquiera de estos aplicativos ya formas parte de la cadena de produccción y reproducción de deepfakes.

¿Hacia dónde van los deepfakes?

Las implicaciones de esta tecnología son inmensas. No se trata solo de los efectos que esto podría tener en las celebridades y otras figuras públicas quienes ya están sometidas a diferentes formas de falsificaciones y engaños manipuladores. También es lo que el intercambio de rostros asistido por IA podría significar para la política, el periodismo y por supuesto el crimen.

Contenidos hiper personalizados

Si bien en este momento se ha utilizado en su mayoría para fines de entretenimiento, imaginemos por ejemplo qué podría pasar en la industria del cine, donde si bien al día de hoy se utilizan tecnologías como CGI para recrear a actores que ya fallecieron, los deepfakes le dan un nuevo giro al uso y derechos de la imagen de un ser humano. sin mencionar que podríamos tener películas actuadas por nuestros actores favoritos, cuántas veces no ha ocurrido que dices “ay, me hubiera gustado que en esta película en lugar de poner a “x” actor/actriz hubieran dejado a “x”.

Con la idea anterior imagínate que ahora cada persona pudiera ver su película favorita actuada por su actor favorito, como ejemplo tenemos el siguiente video donde The Shining presenta repentinamente a Jim Carrey en el papel de Jack Nicholson, está hecho por un artista llamado Ctrl Shift Face.

Está claro que el objetivo (al menos por ahora) de Ctrl Shift Face es entretener en lugar de engañar, sin embargo, reflexiona un poco sobre lo que te comento, películas, series, documentales, actuados por tus actores favoritos, ¿pagarías un extra por eso?

O simplemente imagina que tu actor favorito te manda un mensaje personalizado, algo así como lo que hoy ya existe con Hola Fan pero con deepfakes.

@deeptomcruise Still got it.

♬ origineel geluid – Tom

Este usuario de TikTok ha estado probando en las últimas semanas sus habilidades de creación de deepfakes, si bien y de acuerdo a sus declaraciones esto no lo ha hecho con simplemente apretar un botón proque incluso ha estado trabajando de la mano con un imitador de Tom Cruise, pone en la mesa la idea sobre la nueva explotación de la imagen personal de un ser humano.

Ume (el creador de estos videos) dice que hay muchos usos para los deepfakes, desde el doblaje de actores en cine y televisión, hasta la restauración de imágenes antiguas y la animación de personajes CGI. Lo que enfatiza, sin embargo, es lo incompleto de la tecnología que opera por sí misma.

Rostros digitales falsos para impedir falsificación

Otro de los usos que podemos imaginar es por supuesto el tema de la difamación pero eso es solo el efecto en el presente, piensa en toda la industria que se podría generar alrededor de esto.

Lo que verás a continuación es un video falso de Mark Zuckerberg en donde promociona lo bueno que es tener miles de millones de datos de personas. El objetivo del video es justo concientizar a las personas del riesgo que implica que empresas como Facebook tengan toda nuestra data.

O este otro video falso de la primera ministro de Bélgica vinculando el coronavirus al cambio climático.

A partir de los ejemplos anteriores se están comenzando a crear empresas y servicios para proteger tu identidad, tal es el caso de Generated Media que ofrece un servicio de anonimización para proteger tu identidad en las diferentes redes sociales, esto equivale a tener una imagen que te represente pero que realmente no eres tú.

Podríamos pensar que el intercambio de caras es un juego, pero claramente es solo el comienzo de algo que va más allá. Los avances de la Inteligencia Artificial han marcado el comienzo de una nueva, poderosa y sofisticada falsificación para cualquier tipo de medio, ya sea texto, audio, foto o video.

El uso de deepfakes en la publicidad

Por supuesto que la publicidad no podía quedarse fuera de este “juego”, en los últimos meses hemos visto las aplicaciones de deepfakes en disferentes campañas, entre ellas destacan 3 principales ejemplos.

Lola Flores protagonizando una campaña de Cruzcampo

Ogilvy es la agencia publicitaria que se encuentra detrás del proyecto, y Metropolitana el estudio de efectos especiales y postproducción que lo ha llevado a cabo.

Para el spot, se recuperaron unas 5,000 imágenes de la artista sevillana, que tuvieron que ser optimizadas antes de pasarlas por los dos programas de deepfake que se utilizaron para conseguir el producto final.

En el proceso, contaron con una actriz parecida a Lola Flores y crearon a partir de ella un modelo 3D con el que después trabajarían para darle a las imágenes recopiladas los gestos y los movimientos que se necesitan para conseguir un resultado así de creíble.

Además de utilizar el programa FaceSwap para trasladar la cara real de la cantante a la del modelo 3D, los últimos retoques para que la Lola Flores del vídeo se pareciera a la Lola Flores real hasta en el más mínimo detalle se usó el software DeepFaceLab.

Mi reflexión sobre esto es: ¿Será que comenzaremos a ver entes falsos vendiendonos autenticidad?

La nueva campaña de la Fundación Reina Sofía, ideada por la agencia Sra. Rushmore en la que se «revive» a Salvador Dalí.

Salvador Dalí (quien sufrió Párkinson, una enfermedad neurodegenerativa, y cuya imagen ha sido autorizada desinteresadamente por la Fundación Gala Salvador Dalí), reflexiona sobre el deepfake y contrapone esta Inteligencia Artificial, que cada día ofrece más posibilidades, a la inteligencia natural de la que aún nos queda tanto por conocer.

Así, la campaña invita a reflexionar sobre la diferencia entre los grandes avances de las tecnologías, que actualmente se emplean en eventos, memes, GIFs o videos, y los avances en la inteligencia natural para poder vencer a las enfermedades neurodegenerativas como el Párkinson, el Alzheimer, la Enfermedad de Huntington o la Esclerosis Lateral Amiotrófica (ELA).

Messi mensajes

La marca de papas fritas Lay’s, en colaboración con la más alta tecnología de reconocimiento y mapeo facial, ha dado luz a una nueva herramienta, los “Messi mensajes”. Una plataforma en donde los aficionados, gratuitamente, pueden crear un saludo del famoso argentino.

Con Inteligencia Artificial, los usuarios pueden darle detalles a la plataforma, que está disponible en más de 20 idiomas, para generar mensajes con el nombre de sus amigos. Eso sí, tiene algunas limitaciones, debido a la tecnología que usa, solo hay una cierta cantidad de nombres disponibles.

Lays creó la plataforma junto a Synthesia para unir tecnología de inteligencia artificial, sincronización de labios y mapeo facial para crear los videos personalizados con más de 1,000 nombres disponibles.

Puedes ver el video que cree, aquí.

Por cierto, Synteshia es una herramienta que cualquiera puede usar para “crear un video de Inteligencia Artificial tan fácil como crear un correo electrónico”.

Ahora imagina, si de por sí actualmente la industria de la publicidad rastrea todos tus movimientos en línea, quizás ahora podría hacerlo en el mundo real, tal y como nos lo recuerda esa escena de «Minority Report» en la que el personaje de Tom Cruise huye a través de un centro comercial de anuncios emergentes dirigidos: “John Anderton, podrías ¡usa una Guinness ahora mismo!” Este podría ser nuestro futuro.

Sin olvidar lo que te comentaba hace unos párrafos, ¿qué va a pasar en el futuro con los temas de derechos de uso de imagen? En estos ejemplos que acabo de presentarte los dueños y/o representantes del uso de imagen han colaborado con las marcas y las agencias patra hacer esto posible pero qué pasará en el futuro. ¿Tendremos que crear nuevas versiones de nosotros tokenizados para evitar un nuevo tipo de robo de indentidad?

Tan solo basta con ver el siguiente video para cuestionarnos qué es lo que podría pasar en el futuro.

Detección de deepfakes al estilo de Blade Runner

No sé qué tan fan seas de las películas de ciencia ficción pero en el mundo de la cibercultura la película de Blade Runner marcó un hito, la película nos expone un mundo distópico en el que existen entes llamados “Replicantes” que no son otra cosas que robots antropomorfizados de manera casi perfecta, a dichos replicantes se les emplea en trabajos peligrosos y como esclavos en las “colonias del mundo exterior” de la Tierra.

Los replicantes fueron declarados ilegales en la Tierra tras un sangriento motín ocurrido en una colonia exterior. Un cuerpo especial de la policía, los blade runners, se encargan de identificar, rastrear y “retirar” (no se considera que se les mata sino que se les retira), a los replicantes fugitivos que se encuentran en la Tierra.

La forma que tienen los blade runners de detectar a los replicantes es a través de una prueba llamada Test Voight-Kampff, la prueba requiere una máquina, la máquina mide la variación de funciones corporales tales como la respiración, el rubor, el ritmo cardíaco pero sobre todo, el movimiento de los ojos, en respuesta a una serie de preguntas.

Esto último es muy importante porque recientemente un sistema de expertos de la Universidad de Buffalo alcanzó una precisión del 94% en la búsqueda y reconocimiento de deepfakes.

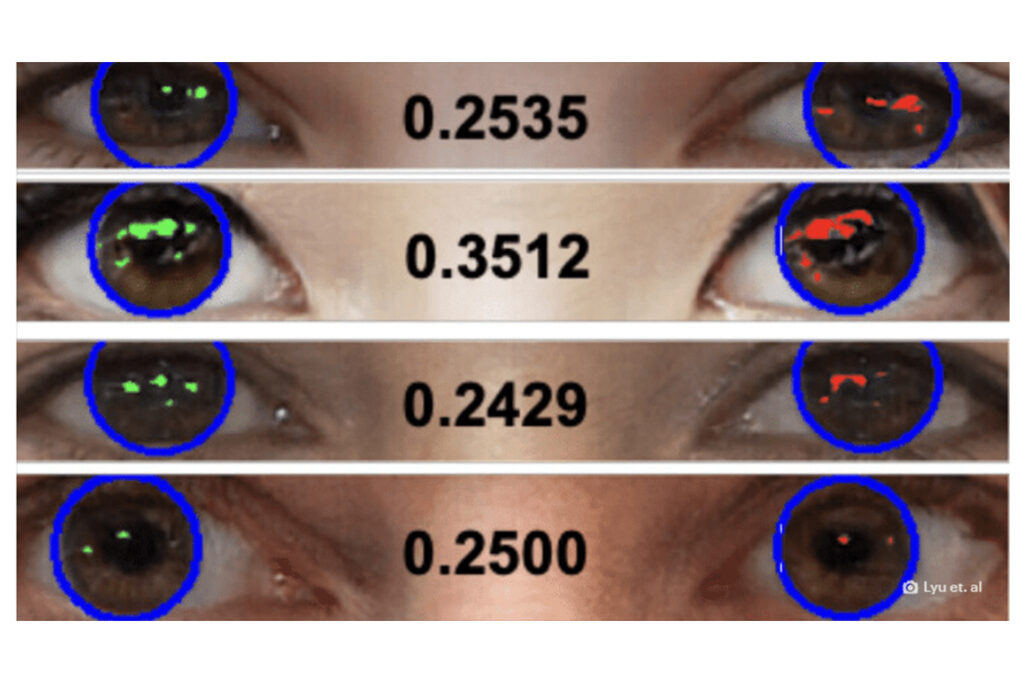

Tal como ocurre en Blade Runner, esta herramienta de IA analiza la córnea de las personas presentes en los videos, determinando si son reales o deepfakes. Esta parte del ojo tiene un aspecto casi espejo, que refleja la luz que incide sobre él. En un video real, ambos ojos tendrán más o menos el mismo reflejo, considerando que la persona estará viendo el mismo objeto. En un video falso, este patrón no se reproduce fielmente ya que el material es generado por computadora.

El sistema de la Universidad de Buffalo mapea los rostros y los ojos de las personas en los videos, buscando estas discrepancias en el reflejo de la luz en las córneas y el iris. Las diferencias pueden variar desde formas geométricas aleatorias hasta la posición y el ángulo incorrectos en el caso de videos falsos. A partir de ahí, la herramienta establece una puntuación numérica: cuanto menor es el valor, mayor es la probabilidad de que el video sea falso.

Sin embargo, los mismos científicos reconocen que existen fallas en el método empleado. Por si fuera poco, trabajar solo en videos grabados en modo retrato (cuando disparas con tu celular parado, por ejemplo), aún depende de una fuente de luz constante y además que ambos ojos sean visibles para la captura. Cualquier cosa que se desvíe de este patrón hará que el sistema presente falsos positivos.

El equipo de la Universidad de Buffalo está ahora mismo trabajando para mejorar estos defectos y actualizar la función, lo que puede llevar mucho tiempo y mucha investigación.

Mientras tanto, ahora mismo tú puedes poner a prueba tus habilidades de detección de deepfakes utilizando el siguiente enlace, llamado Deep Angel, desarrollado por el MIT, con esta plataforma, puedes explorar el futuro de la manipulación automatizada de medios cargando tus propias fotos o intentando detectar videos falsos.

Lentes de Realidad Real

En Blackbot a partir de todas estas señales y tendencias hemos creado un proyecto de diseño especulativo al que hemos llamado “Lentes de Realidad Real” diseñados para ese mundo en el que ya no podemos detectar lo real de lo artificial.

Si quieres saber más de este proyecto puedes consultarlo en nuestro perfil de Behance o dando clic aquí.

La lección que nos queda de todo esto es:

Cuida tu rostro es el único que tendrás toda la vida.