No hay productos en el carrito

No, este no es un artículo o post más sobre las cien mil y una cosas que puedes hacer con IA, es una reflexión sobre la mal llamada inteligencia artificial generativa que en los últimos meses está ganando una gran popularidad y aplicación en una amplia gama de industrias y ámbitos. Sin embargo, a medida que la tecnología avanza, es importante cuestionar su impacto en nuestra sociedad y cultura. ¿Estamos dejando que la IA generativa nos distraiga de lo verdaderamente importante? En este artículo, abordaremos esta cuestión crítica y exploraremos cómo la IA está afectando nuestra capacidad para abordar los desafíos más importantes que enfrenta nuestra sociedad. Consideraremos la necesidad de un debate público sobre el papel que debe desempeñar la tecnología en nuestras vidas.

1.- Mira! Una nueva tecnología

¿Te has dado cuenta lo fácil que es distraer nuestra atención? No te preocupes, podemos decir que no es culpa nuestra sino de la dopamina, ese neurotransmisor, ese químico producido por el cerebro que juega un papel importante en el sistema de recompensa y motivación. Eso que en el cerebro provoca una sensación de bienestar y recompensa que nos impulsa a repetir la acción o experiencia que lo causó. Ese químico que en algún momento nos ayudó a buscar y encontrar recursos necesarios para la supervivencia, como alimentos y agua pero que ahora pareciera que nos obliga a buscar algo nuevo, una nueva distracción, llevándonos a una dependencia y a una constante insatisfacción que insisto, pareciera que solo se puede saciar con lo nuevo.

El tema es que en esta búsqueda insaciable se nos olvida que “lo nuevo” pocas veces lo es. Hace unos cuantos meses todo el mundo hablaba de criptomonedas, después todo mundo habló de metaversos y ahora todo el mundo está hablando de inteligencia artificial generativa. Y no es que hablar de las tecnologías esté mal en sí mismo, el tema es cómo nos dejamos arrastrar por cada ola sin detenernos a reflexionar y hacernos preguntas tan básicas como ¿De dónde vino esto? ¿Cuál es su origen? ¿Cuándo fue su origen? ¿A dónde nos está llevando? ¿A dónde nos podría llevar?

Sin embargo, en lugar de cuestionar nos conformamos con convertirnos en una cámara de eco, en una reverberancia de lo que todo mundo está diciendo y cuando todos hablan y/o piensan lo mismo, en realidad nadie está hablando ni pensando nada.

Mientras tanto, por supuesto el mundo sigue su curso, seguimos enfrentando problemas complejos como el cambio climático, los conflictos bélicos, despidos masivos, educación rezagada y un largo etcétera que pareciera no importarnos porque estamos cegados por el flash de ChatGPT y de la inteligencia artificial.

Por eso, hoy me he tomado el tiempo para invitarte a reflexionar sobre lo que nos está ocurriendo y sobre cómo seguimos esperando a un mesías ya sea de manera literal o metafórica, seguimos en la ingenuidad de que una tecnología lo va a revolucionar todo y le endosamos todas las responsabilidades que nos tocan a nosotros y que deberíamos estar resolviendo en lugar de alabar a una tecnología que posiblemente ni siquiera terminamos de entender.

2.- Antecedentes de la inteligencia artificial

Hagamos un breve viaje para entender de dónde viene todo esto.

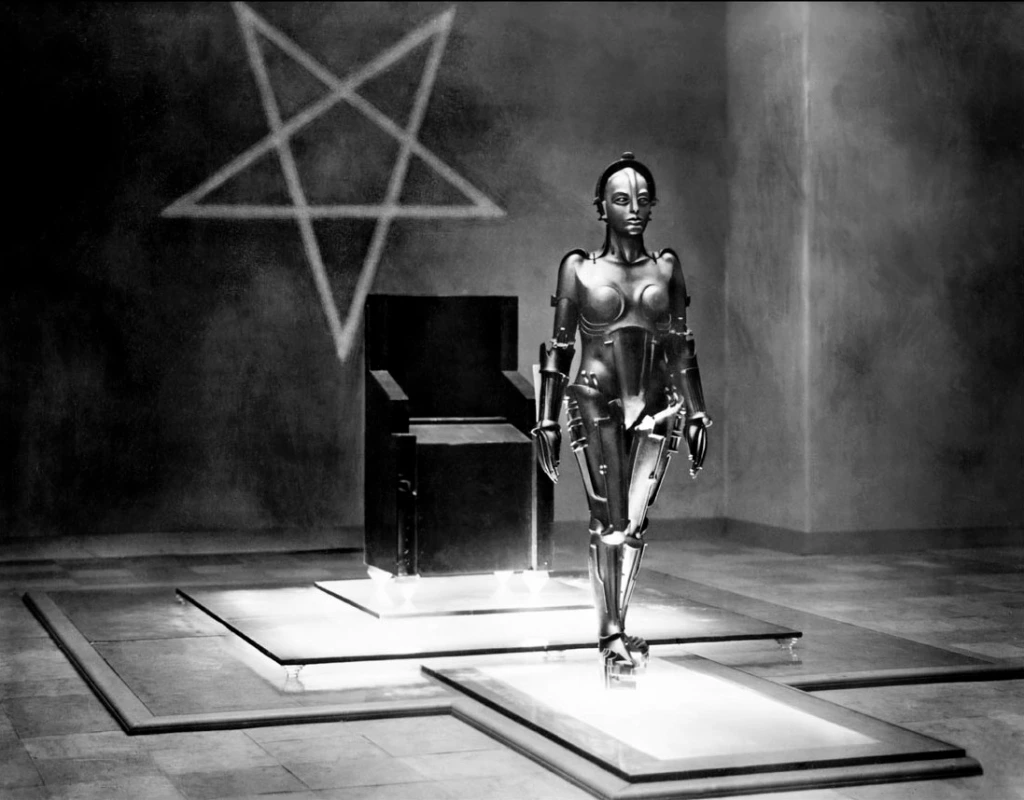

En la primera mitad del siglo XX, la ciencia ficción presentó al público la idea de robots dotados de inteligencia artificial. Desde el hombre de hojalata «sin corazón» en «El Mago de Oz» hasta la aparición de María como un robot humanoide en «Metrópolis», la imaginación popular exploró esta fascinante posibilidad. En la década de 1950, una nueva generación de científicos, matemáticos y filósofos tenía incorporado culturalmente el concepto de la inteligencia artificial (IA). Uno de estos pensadores fue Alan Turing, un joven erudito británico que investigó la posibilidad matemática de la IA.

En su artículo de 1950, «Computing Machinery and Intelligence«, Turing propuso que los humanos usan la información disponible y la razón para resolver problemas y tomar decisiones. Entonces, ¿por qué las máquinas no podrían hacer lo mismo? Este marco lógico sentó las bases para la construcción de máquinas inteligentes y la evaluación de su inteligencia. Con esta obra, Turing sentó las bases para la exploración futura en el campo de la inteligencia artificial.

Cinco años después del artículo de Alan Turing, el concepto comenzó a tomar forma en la práctica. En 1955, Allen Newell, Cliff Shaw y Herbert Simon dieron vida a «The Logic Theorist«, el primer programa de inteligencia artificial conocido. Este proyecto fue financiado por la RAND Corporation y demostró las capacidades de una máquina para imitar las habilidades de resolución de problemas de un ser humano.

En 1956, John McCarthy y Marvin Minsky organizaron la famosa Conferencia de Dartmouth sobre Inteligencia Artificial (DSRPAI), en la que se presentó «The Logic Theorist». En este evento histórico, McCarthy, el acreditado por acuñar el término «inteligencia artificial», reunió a los líderes de diferentes campos para una discusión abierta sobre el futuro de la IA. A pesar de que la conferencia no cumplió con sus expectativas, todos los presentes estaban comprometidos con la idea de que la IA era alcanzable. Este momento fue clave para impulsar la investigación en IA durante los próximos 20 años.

Entre 1957 y 1974, la inteligencia artificial experimentó un boom. Las capacidades de almacenamiento y velocidad de las computadoras mejoraron, haciéndolas más asequibles y económicas. Al mismo tiempo, los algoritmos de aprendizaje automático se perfeccionaron, y los expertos desarrollaron habilidades para identificar cuál era el más adecuado para resolver un problema dado. Destacables entre las primeras demostraciones de IA fueron el Solucionador General de Problemas de Newell y Simon y ELIZA de Joseph Weizenbaum, que demostraron el potencial para la resolución de problemas y la comprensión del lenguaje natural, respectivamente.

Estos logros, así como la influencia de los líderes en el campo de la IA, llevaron a las agencias gubernamentales a financiar investigaciones en este campo en diferentes instituciones. Entre ellas, la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) mostró un interés especial en el desarrollo de una máquina capaz de transcribir y traducir el lenguaje hablado, así como de realizar procesamientos de datos de alto rendimiento. A pesar del optimismo general, las expectativas eran aún más altas. En 1970, Marvin Minsky afirmó en una entrevista con la revista Life que en un período de entre tres y ocho años se lograría una máquina con la inteligencia general de un ser humano promedio. Sin embargo, aunque se había demostrado el principio básico, aún faltaba mucho por hacer antes de alcanzar los objetivos finales de procesamiento del lenguaje natural, pensamiento abstracto y autoconciencia.

El surgimiento inicial de la inteligencia artificial se topó con una serie de obstáculos, especialmente en términos de capacidad computacional insuficiente. La tecnología de la época no podía almacenar y procesar la información requerida para exhibir inteligencia. La investigación avanzó lentamente durante décadas debido a la falta de financiamiento y paciencia.

Sin embargo, a partir de la década de 1980, la IA experimentó un renacimiento gracias al aumento de los fondos y una ampliación de las herramientas algorítmicas. John Hopfield y David Rumelhart popularizaron técnicas de «aprendizaje profundo», mientras que Edward Feigenbaum presentó sistemas expertos que imitaban el proceso de toma de decisiones de un humano. Estos esfuerzos recibieron amplio apoyo financiero del gobierno japonés a través de su Proyecto informático de quinta generación (FGCP). Aunque no se cumplieron todos los objetivos ambiciosos del FGCP, su impacto indirecto inspiró a una generación de ingenieros y científicos.

Extrañamente, fue en la ausencia de financiamiento gubernamental y publicidad, cuando la IA floreció. Durante las décadas de 1990 y 2000, se lograron muchos de los objetivos históricos de la IA, incluyendo la victoria de Deep Blue de IBM sobre el campeón mundial de ajedrez Gary Kasparov en 1997, y la implementación de software de reconocimiento de voz en Windows. Incluso la emoción humana se convirtió en un juego justo para las máquinas, como lo demuestra el robot Kismet desarrollado por Cynthia Breazeal, que podía reconocer y mostrar emociones.

Ahora bien, ¿qué es lo que ha pasado desde ese entonces a la fecha? Malas noticias:

Nuestra comprensión de la codificación de la inteligencia artificial no mejoró ni se volvió más sofisticada, simplemente lo que cambió fue la disponibilidad de capacidades de almacenamiento y procesamiento en las computadoras. La Ley de Moore, que apuntaba a un aumento en la memoria y velocidad de las computadoras cada año, finalmente ha alcanzado y, en muchos casos, ha superado nuestras expectativas. Esto explica cómo sistemas como Deep Blue y Alpha Go han podido superar a campeones humanos en juegos de inteligencia. La investigación en IA se ha mantenido en una montaña rusa, alcanzando los límites de nuestro poder computacional actual antes de esperar la próxima actualización de la Ley de Moore.

Por lo tanto, aunque ChatGPT de OpenAI puede ser considerado el logro más emblemático en inteligencia artificial del último siglo, siendo honestos debemos decir que actualmente su rendimiento es muy «regular».

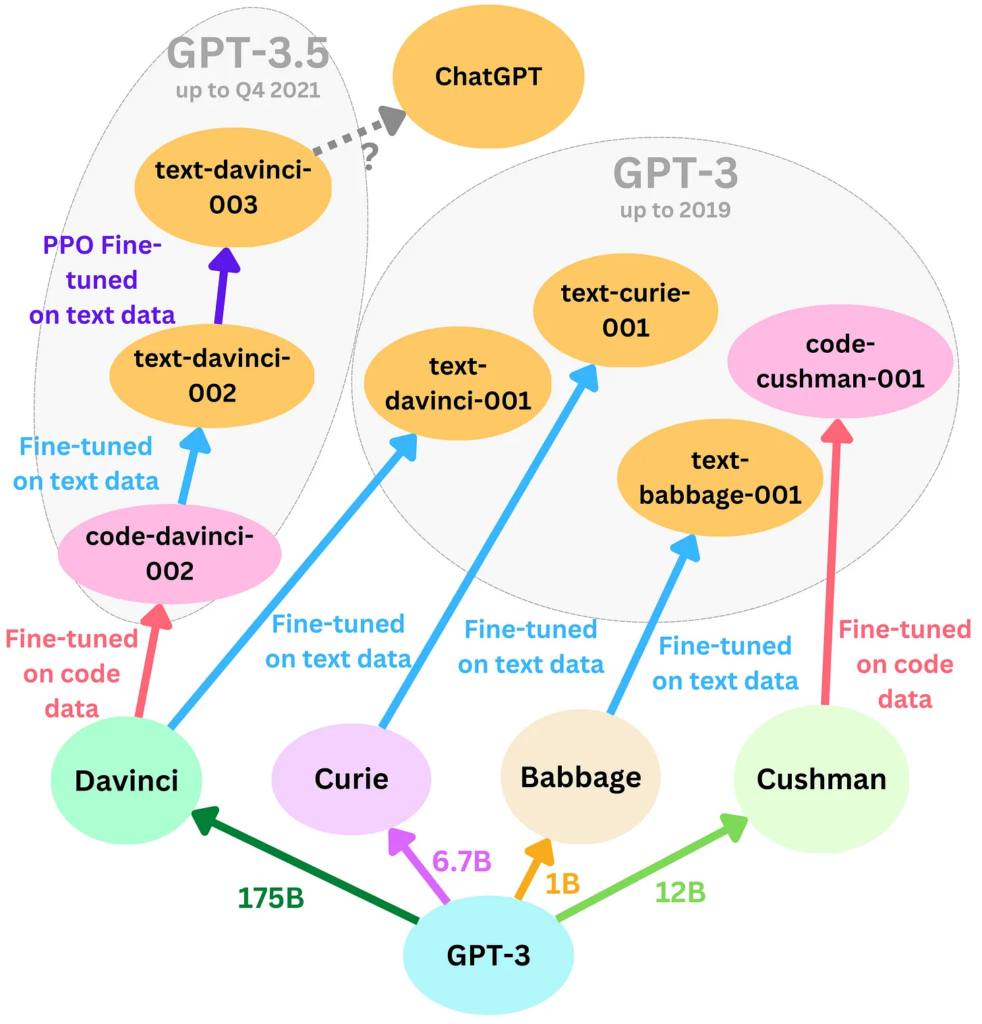

Ahora, eso no quita que, sin duda, es la IA más impresionante a la que el público ha tenido acceso y este logro se debe a la incorporación de retroalimentación humana en la creación de ChatGPT ya que OpenAI ajustó su modelo base, GPT-3, a través de interacciones humanas y calificaciones de respuestas para mejorar su capacidad para producir respuestas satisfactorias para los usuarios.

Por lo tanto, el logro de ChatGPT es que está evolucionando de ser una tecnología para convertirse en un medio, tal como le pasó al cine.

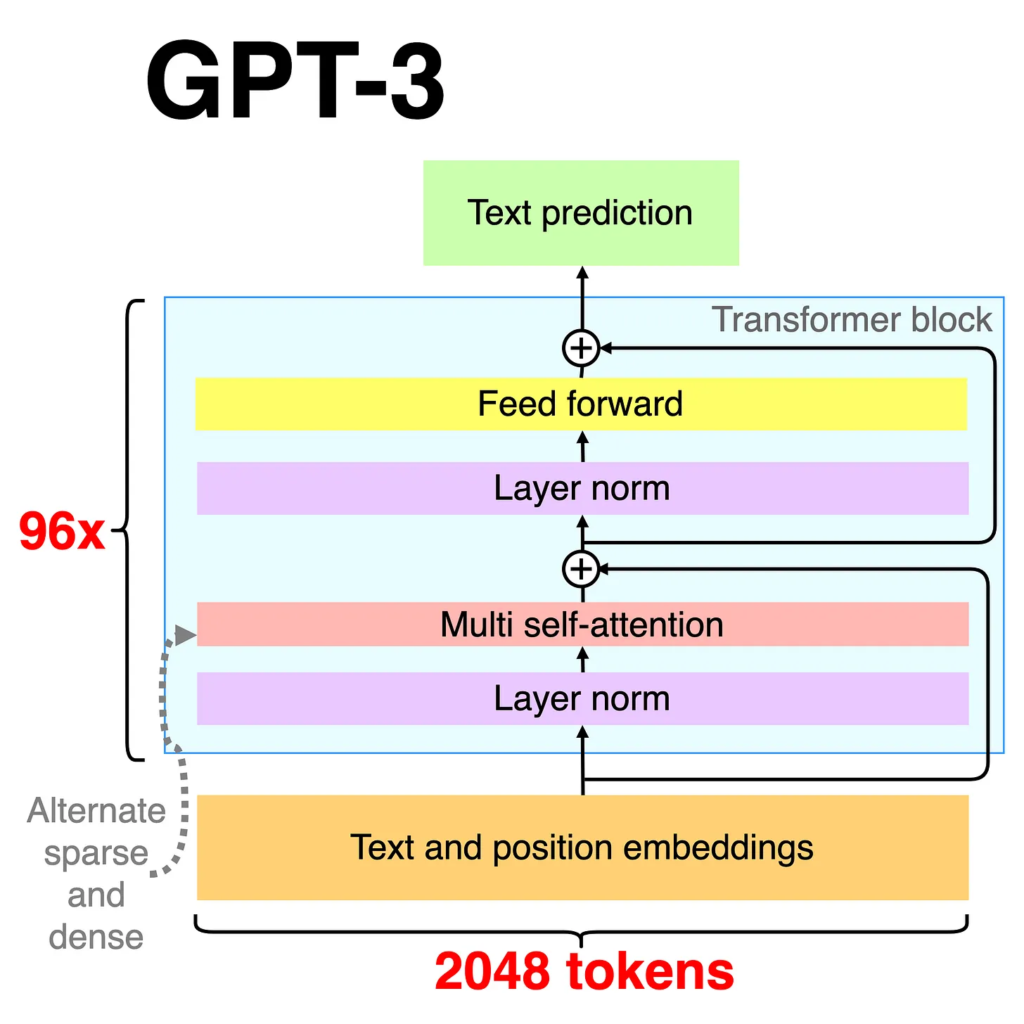

Si no me creen, analicemos lo siguiente, hay más en GPT-3 que solo GPT-3. En la API disponible de OpenAI, GPT-3 representa una flota de diferentes modelos que se distinguen por el tamaño, los datos utilizados y la estrategia de entrenamiento. El modelo central GPT-3 es la fuente de todos esos modelos derivados.

3.- El impacto de la IA en nuestra labor humana

Antes de seguir adelante, aclaremos algo, la llamada inteligencia artificial generativa, ni es inteligente ni es generativa, ahora te explico por qué.

Supuestamente, la inteligencia artificial generativa es una subramificación de la inteligencia artificial que se enfoca en la creación de nuevos contenidos y soluciones “originales” a partir de un conjunto de reglas y algoritmos previamente establecidos. El término «inteligencia artificial generativa» fue acuñado por el artista y teórico de la tecnología Mitchell Whitelaw en su libro «Generative Art: A Practical Guide Using Processing».

Por otro lado, la inteligencia artificial que no es generativa se supone que se enfoca en la ejecución de tareas específicas basadas en la información previamente proporcionada.

Sin embargo, aquí hay una confusión, en términos simples, la Inteligencia Artificial y el aprendizaje automático son dos disciplinas distintas. Mientras la IA se enfoca en la construcción de sistemas que pueden demostrar inteligencia humana, el aprendizaje automático es un campo estadístico centrado en el aprendizaje a partir de datos. Por lo que, la llamada IA generativa se basa en el uso de redes neuronales, una forma avanzada de aprendizaje automático que permite a los sistemas aprender y mejorar su rendimiento a medida que procesan más datos.

Aunque a menudo se confunden, la IA y el aprendizaje automático tienen una tradición y una génesis muy distintas. Como mencioné anteriormente, la IA se originó en la década de 1950 como un intento de usar las computadoras para replicar la inteligencia humana y comprenderla a través de la resolución de problemas. Por otro lado, el aprendizaje automático se basa en la idea de simular las interacciones de las neuronas cerebrales y tiene sus raíces en el campo de la estadística.

De este modo, los sistemas de IA (generativa) están entrenados en vastos corpus de datos creados por humanos y, a pesar de las objeciones en contrario, requieren aportes humanos para una adopción generalizada. Así que aún no están generando nada, simplemente están utilizando aprendizaje automático.

Tan es así que la labor de etiquetado preciso de los datos que alimentan a los sistemas de aprendizaje automático previos es el resultado del trabajo subyacente, y a menudo mal remunerado, de miles de trabajadores ubicados en los países del Sur Global. Por ejemplo, para entrenar su modelo ChatGPT, OpenAI contrató a una empresa subcontratada en Kenia para que etiquetara fragmentos de texto con respecto a la toxicidad.

Así como las primeras aplicaciones comerciales de las redes neuronales en los años 80 requerían la intervención humana para corregir errores en la clasificación de correo, la adopción generalizada de la IA requerirá la supervisión, la corrección y la adaptación por parte de los humanos.

Como resultado de ello, el empleo de profesionales para supervisar dichos sistemas se verá significativamente incrementado. La intervención humana será esencial para asegurar un desempeño fiable, ya que proporcionará aquello que las técnicas de aprendizaje automático no pueden: una comprensión del significado.

Tomemos, como ejemplo, los modelos de texto a texto. A pesar de su impresionante presentación y las cuestionables implicaciones sobre su importancia en la investigación en IA, estos sistemas son en esencia predictores de la próxima palabra, careciendo de una comprensión profunda del significado subyacente de las palabras que generan.

Además, la falta de comprensión de significado es un obstáculo no solo para la confianza en los sistemas actuales de aprendizaje automático. También es un problema a futuro, ya que estos sistemas generan los resultados sobre los que se entrenarán los sistemas futuros. Esta dinámica crea un ciclo perjudicial que no solo amenaza con impulsar la producción de información falsa, como resultado de la generación de texto que suena convincente pero incorrecto, sino que también presenta un desafío para encontrar y recuperar información precisa en un océano de datos equivocados.

Ahora bien, aunque no sean propiamente IA generativa lo que sí es verdad es que la capacidad que poseen herramientas como ChatGPT para brindarnos una cantidad masiva de opciones en un corto tiempo es realmente impresionante. Sin embargo, hay algo que aún no hacen bien y no deberíamos dejar que hicieran: discernir y elegir.

Esa es, según Jerry Seinfeld, la habilidad máxima del artista (humano): «gusto y discernimiento».

“Una cosa es crear”, dijo Seinfeld. “La otra es que tienes que elegir. ‘¿Qué vamos a hacer y qué no vamos a hacer?’ Este es un aspecto gigantesco de la supervivencia. Es un poco invisible, lo que se elige y lo que se descarta, pero dominar eso es cómo te mantienes con vida”.

Herramientas como ChatGPT son excelentes para crear. La IA puede generar opciones en grandes cantidades a alta velocidad. Es excelente para proporcionar más opciones. Pero no es buena para discernir y elegir qué hacer y qué no hacer.

Cuando una obra artística, ya sea un libro, un álbum musical, una película, una serie o un video en línea, tiene una resonancia positiva con el público, decimos que ha logrado conexión. La obra ha establecido un vínculo con su audiencia, con los seres humanos.

Para establecer una conexión con los seres humanos, es fundamental estar en contacto con ellos. Leonardo da Vinci solía llevar una libreta en su cinturón, y según relató uno de sus contemporáneos, «solía visitar lugares donde sabía que la gente se reunía, y observaba sus rostros, sus maneras, sus ropas y sus gestos». JK Rowling tuvo la idea inicial de Harry Potter en un viaje en tren de Manchester a Londres, escribió gran parte de la serie en cafeterías y basó algunos personajes en amigos de su infancia y otros en sus profesores favoritos.

Para conectar con el público, es necesario tener un conocimiento profundo y práctico de la realidad humana. La inteligencia artificial, carente de experiencias empíricas, encontrará dificultades en la creación de obras que en realidad conmuevan y conecten profundamente con las personas.

La IA tiene datos. Pregúntale sobre libros, y podrá escupir una lista de los 100 mejores. Pero no es capaz de elegir una lista fuera de las narrativas dominantes, seguirá mostrando resultados donde más del 90% de ese listado sean hombres y mucho menos podrá citarte un pasaje expresando perfectamente algo que has sentido pero que no has podido articular.

Pregúntale sobre música y podrá escribirte letras al estilo de quien quieras. Pero la IA nunca ha llorado con una canción. Pregúntale acerca de dar un paseo, y podrá darte razones respaldadas por la ciencia para hacerlo. Pero la IA nunca ha estado en un paseo, nunca ha estado totalmente emocionada por un pensamiento o una idea que pareciera surgir de la nada.

Pregúntale sobre el café o sobre tu bebida favorita y te podrá dar una infografía que detalla decenas o cientos de métodos de preparación. Pero la IA nunca ha tenido la sensación de esa primera taza del día. Este sigue siendo un tema humano y es en eso donde deberíamos enfocarnos y recordar que la IA no es el mesías que muchos esperan, es una herramienta que vaya que puede potenciarnos pero que debemos cuestionar y sobre todo regular.

El mismo Joseph Weizenbaum, sí el del proyecto ELIZA del que te conté arriba, advirtió en su libro de 1976, Computer Power and Human Reason, que a medida que la tecnología de la informática se desarrolla, la tendencia humana es a confiar en ella en lugar de en la razón y el juicio humano. El autor argumentaba que, aunque las computadoras tienen una gran capacidad para realizar cálculos y solucionar problemas, es importante que la humanidad mantenga su capacidad para pensar críticamente y no delegue completamente su razón a la tecnología. El libro es una reflexión muy necesaria en el presente sobre la naturaleza de la inteligencia y la razón humanas y sus límites en comparación con la tecnología.

¿Estamos dispuestos a dejar en manos de la IA nuestras decisiones? Porque al final, ese es el trato que la IA está poniendo sobre la mesa. ¿O estamos esperando que salga la siguiente herramienta para volvernos a distraer y olvidarnos una vez más de todo?